翻译转载自: https://buttondown.email/ainews/archive/ainews-zero-to-gpt-in-1-year/

正如许多人所料,4月发布的GPT4T再次登顶LMsys,现已在付费版ChatGPT和一个全新的轻量级模型评估Repo中推出。我们此前曾提到,OpenAI将需要优先在ChatGPT中推出新模型,以助推增长。

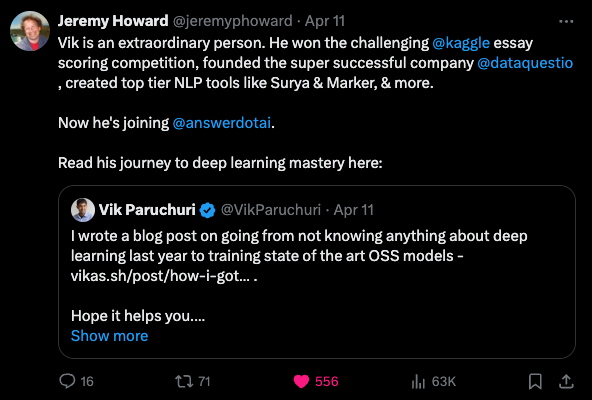

总的来说,这是即将到来的Llama 3发布会前的一段宁静时刻。你可以查看Elicit的论文/播客或Devin vs OpenDevin vs SWE-Agent的直播。不过,我们今天要特别提一下Vik Paruchuri,他撰写了一篇文章,描述了自己从工程师到在1年内打造出出色的OCR/PDF数据模型的历程。

GPT-4 and Claude Updates

- GPT-4 Turbo重新登顶排行榜榜首:@lmsysorg指出,GPT-4 Turbo在编程、更长查询和多语言能力等多个领域的表现均优于其他模型,已重新夺回了Arena排行榜第一名的位置。在仅包含英文提示和代码片段的对话中,它的表现更加出色。

- 发布全新的 GPT-4 Turbo 模型:@sama 和 @gdb 宣布在 ChatGPT 中推出了一款全新的 GPT-4 Turbo 模型,该模型大幅提升了智能性和使用体验。@miramurati 确认这是最新版的 GPT-4 Turbo。

- 新 GPT-4 Turbo 的评估数据: @polynoamial 和 @owencm 分享了评估结果, 与上一版本相比, MATH 提高了 +8.9%, GPQA 提高了 +7.9%, MGSM 提高了 +4.5%, DROP 提高了 +4.5%, MMLU 提高了 +1.3%, HumanEval 提高了 +1.6%。

- Claude Opus仍优于新GPT-4:@abacaj和@mbusigin指出,在他们的使用中,Claude Opus较新GPT-4 Turbo模型更加智能、创造力更强。

Open-Source Models and Frameworks

- Mistral模型:@MistralAI发布了新的开源模型,包括Mixtral-8x22B基础模型,这是一款很适合进行微调的强大模型(@_lewtun),以及Zephyr 141B模型(@osanseviero, @osanseviero)。

- Medical mT5模型: @arankomatsuzaki分享了一个面向医疗领域的开源多语言文本到文本的大型语言模型 Medical mT5。

- LangChain 与 Hugging Face 集成: @LangChainAI 发布了跨模型提供商支持工具调用的更新,并提供了一个标准的

bind_tools方法用于将工具附加到模型。 @LangChainAI 还更新了 LangSmith,以支持在各种模型的跟踪中渲染工具和工具调用。 - Hugging Face Transformer.js:@ClementDelangue指出,Transformer.js - 一个在浏览器中运行Transformer模型的框架 - 出现在Hacker News上。

Research and Techniques

- 从 Words 到 Numbers - LLMs 作为回归器: @_akhaliq 分享了研究结果,分析了预训练的 LLMs 在给定上下文示例时,能够进行线性和非线性回归,并且可以媲美或优于传统的监督学习方法。

- 高效无限上下文Transformers: @_akhaliq分享了来自谷歌的一篇论文,介绍了如何将压缩记忆整合到常规注意力层中,使Transformer大语言模型能够以有限的内存和计算处理无限长的输入。

- OSWorld基准测试:@arankomatsuzaki 和 @_akhaliq 分享了 OSWorld,这是首个可扩展的真实计算机环境基准测试,适用于多模态智能体,支持任务设置、基于执行的评估以及在各种操作系统上的交互式学习。

- ControlNet++: @_akhaliq 分享了 ControlNet++,该模型通过高效的一致性反馈手段改善了扩散模型中的条件控制能力。

- Applying Guidance in Limited Interval:@_akhaliq分享了一篇论文,表明在有限区间内应用引导能够提升扩散模型中的样本和分布质量。

Industry News and Opinions

- WhatsApp 与 iMessage 论辩: @ylecun将 WhatsApp 与 iMessage 的论辩比作公制与英制系统的争论,指出除了一些狂热使用 iPhone 的美国人或被禁止使用的国家外,全世界都在使用 WhatsApp。

- AI Agent将广泛应用: @bindureddy预测 AI 代理将无处不在,使用 Abacus AI,您可以在短短 5 分钟到几小时内搭建这些Agent。

- Cohere Rerank 3 model: @cohere和@aidangomez推出了Rerank 3,这是一个用于增强企业搜索和RAG系统的基础模型。该模型能够在100多种语言中准确检索多方面和半结构化数据。

- OpenAI 因信息泄露解雇员工: @bindureddy 报告称 OpenAI 解雇了 2 名员工,其中 1 人是 Ilya Sutskever 的亲密朋友,原因是泄露了一个内部项目的信息,很可能与 GPT-4 有关。

-

Mixtral 和 Mistral 模型正在获得关注:Mixtral-8x22B 和 Mistral-22B-v0.1 模型正在引起关注,后者标志着首次成功将 Mixture of Experts (MoE) 模型转换为密集格式。讨论集中在它们的功能上,如 Mistral-22B-v0.1 拥有 22 亿参数。最近发布的 Zephyr 141B-A35B,是 Mixtral-8x22B 的 Fine-tuned 版本。

-

Rerank 3和Cohere的搜索增强功能:Rerank 3,这是Cohere针对企业搜索和RAG系统推出的新型基础模型,支持100多种语言,拥有4k的上下文长度,并提供高达3倍的推理速度。该模型原生集成了Elastic的推理API以支持企业搜索。

-

CUDA优化和量化探索:工程师优化CUDA库如CublasLinear, 以实现更快的模型推理,同时也在探讨4位、8位以及全新的高质量量化(HQQ)等量化策略。通过修改NVIDIA驱动程序, 可实现在4090 GPU上开启P2P支持,从而显著提升速度。

-

一篇新论文《"Scaling Laws for Data Filtering"》认为,数据整理工作不能忽视计算因素,并提出了处理非均匀网络数据的扩展法则。该研究社区正在探讨其含义并尝试理解所采用的实证方法。

其他值得关注的讨论包括:

- 推出了 GPT-4 Turbo 及其在编码和推理任务中的性能表现

- Ella的动漫图像生成能力欠佳

- 对于 Stable Diffusion 3 及其在解决当前模型限制方面的潜力的期待

- Hugging Face的Rerank模型下载量已达23万,且parler-tts库已正式发布。

- 围绕 OpenAI API、Wolfram 集成和 prompt 工程资源的讨论